Evolución de la Voz Sintética

Noti 371 – enero de 2026

Nota editorial: En ASR S.A.S. utilizamos la tecnología para protegerte. La investigación y estructuración de este artículo contó con la asistencia de herramientas de Inteligencia Artificial, supervisadas por nuestros expertos en seguridad.

Imagen de Canva

En nuestro Noti 347 del mes de marzo de 2024 abordamos el tema de la voz sintética. Para ese momento, la tecnología requería de grabaciones largas y herramientas costosas, limitando los ataques a figuras públicas. Sin embargo, la realidad ha cambiado rápidamente. Hoy la tecnología es de fácil acceso, convirtiéndonos a todos en objetivos potenciales.

Caso Jay Shooster: Un espejo del futuro.

En septiembre de 2024, un caso reportado por el New York Post encendió las alarmas globales. El padre del político norteamericano Jay Shooster estuvo a segundos de transferir USD $35.000 a unos delincuentes. ¿El motivo? Recibió una llamada de su «hijo» alegando haber sufrido un accidente grave y estar detenido. La voz era idéntica, clonada a partir de un fragmento de solo 15 segundos de una aparición en televisión.

¿Qué salvó al padre de la estafa? Un detalle técnico en medio del pánico: el supuesto abogado exigió el pago de la fianza a través de un cajero de criptomonedas, un método atípico para el sistema legal, lo que despertó la sospecha final.

¿Les suena familiar? En Colombia es muy usual recibir llamadas de familiares y amigos que dicen estar en problemas y solicitan una cantidad de dinero para resolver su situación e inclusive, han pedido sacar objetos y dinero de las viviendas para entregarlos en sitios específicos a personas con ciertas características. Es una modalidad que no es nueva, existe desde la utilización de teléfonos fijos; la diferencia radica en la tecnología que utilizan. Antes se intentaba simular una voz, recurrían a “ sitios comunes” (soy tu primo, tu hermano, tu hija, etc.), ahora toman nuestra voz y la clonan para eliminar cualquier tipo de suspicacia o duda de la víctima potencial.

¿Cómo funciona esta tecnología?

En la actualidad, herramientas como VALL-E (Microsoft) pueden clonar una voz con solo 3 segundos de audio, mientras que otras, como Voice Engine de OpenAI, requieren cerca de 15 segundos para lograr una similitud asombrosa.

Los delincuentes obtienen estos insumos mediante la «Cosecha de Voz» (Voice Harvesting), extrayendo audio de videos en redes sociales y notas de voz. En Colombia, por ejemplo, hay una tendencia en crecimiento de recibir llamadas silenciosas, las cuales pueden ser una táctica para capturar la voz de una persona. Quien recibe la llamada contesta con su tradicional “Aló”, “Hola”; mientras al otro lado hay un silencio absoluto que lleva a la potencial víctima a repetir el saludo o a decir frases más largas como: “¿Quién habla?” O “No se le escucha, vuelva a marcar”; proporcionando los elementos necesarios para clonar la voz de la víctima. Esta técnica se puede combinar con ingeniería social para poder estafar a familiares y amigos, aunque también puede utilizarse para autorizar acciones fraudulentas o contratos verbales, si logran que digas, por ejemplo, “Sí”, o “De acuerdo” durante la conversación.

Combinación Peligrosa

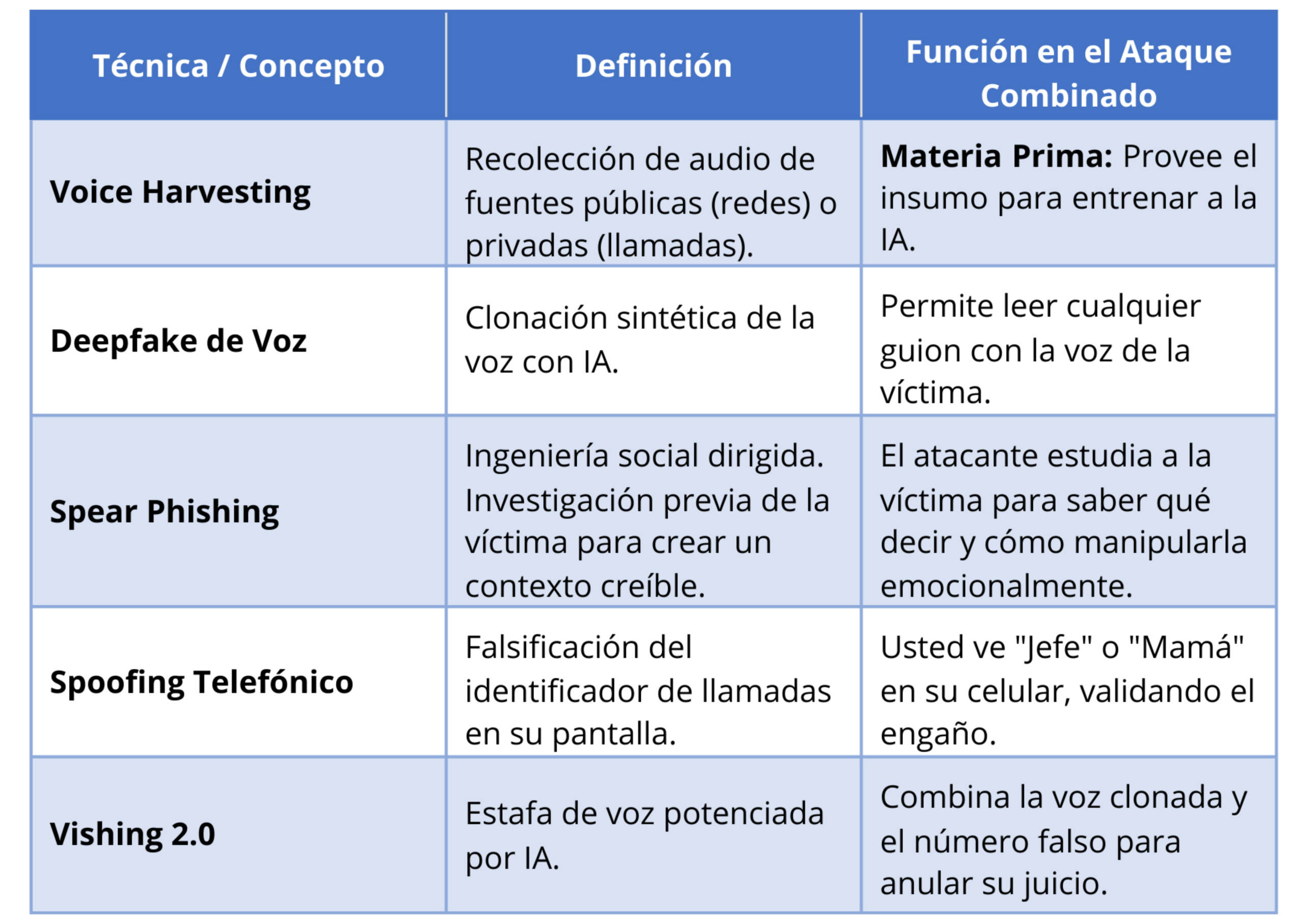

Existen técnicas o modalidades que los delincuentes suelen combinar:

Imagen de Canva

Bibliografía y Fuentes de Consulta:

Bautista Romero, L. (2025). Pilas: están clonando voces con IA, aprenda a protegerse. El Colombiano. Recuperado de: elcolombiano.com

Edwards, B. (2023). Microsoft new AI can simulate anyone’s voice with 3 seconds of audio. Ars Technica.

Forbes Staff. (2024). Colombia está en el top 10 de países con más llamadas spam y de estafas telefónicas. Forbes Colombia.

Simpson, M. L. (2024). Fla. pol targeted in elaborate AI ‘car crash’ scam. New York Post.

Ataque Combinado

Vamos a ver cómo se combinan diferentes modalidades para suplantar a un gerente, director o CEO:

Fase 1: Reconocimiento (Spear Phishing + Voice Harvesting): El atacante investiga a la empresa. Descarga un video del CEO de alguna red social o le realiza una «llamada silenciosa» para capturar su huella vocal. Con esto, diseñan un guion creíble basado en la jerarquía real de la compañía.

Fase 2: Armado (Deepfake): Usando software de clonación, entrenan un modelo de IA en minutos. Ahora pueden hacer que la voz del CEO diga frases que nunca pronunció, como «Autoriza esta transferencia urgente a este proveedor»

Fase 3: Ejecución (Vishing 2.0 + Spoofing): El teléfono del empleado suena. En la pantalla aparece: «Oficina del CEO» (Spoofing). Al contestar, escucha la voz exacta de su jefe con tono de urgencia (Deepfake). La combinación de autoridad visual y auditiva anula las defensas lógicas de la víctima.

Si bien es cierto que la tecnología avanza rápidamente, mientras que nuestro conocimiento va a un ritmo más lento, podemos hacer pequeñas cosas que pueden marcar la diferencia:

- Al contestar números desconocidos, no hable primero. Espere 2 o 3 segundos en silencio. Si es una máquina recolectora, usualmente colgará.

- Nunca conteste con un «Sí». Podría ser grabado para autorizar fraudes.

- Si lo llaman pidiendo dinero o datos urgentes, cuelgue. Llame usted mismo al número que tiene guardado de esa persona y nunca devuelva la llamada al número desde el cual le realizaron la llamada.

- Establezca una frase de seguridad con su familia o equipo de trabajo para verificar la identidad en situaciones de supuesta emergencia; y jamás la comparta a través de mensajes.

Imagen de Canva

Por: Laura Castrillón

Directora de Operaciones

ASR S.A.S.

Medellín, Colombia

+573103923352 – 3233453366

asr@asr.com.co